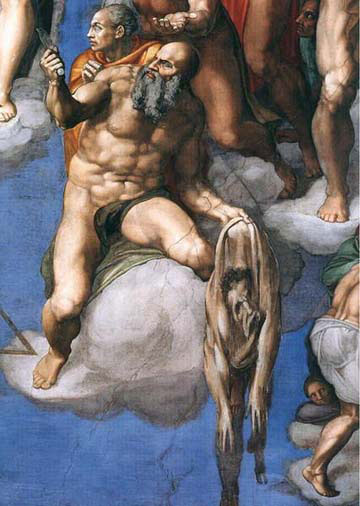

Michel-Ange : Le jugement dernier détail, (Vatican, Chapelle Sixtine). Saint Barthélemy tient, d’une main, le couteau, avec lequel il fut écorché vif en Arménie, et, de l’autre, sa peau dans laquelle on peut voir un autoportrait de l’artiste.

KULTURPOLITIK NACH BORIS DJACENKO

Boris Djacenko sagte mir Nach dem Verbot

Meines Romans HERZ UND ASCHE Teil zwei

In dem zum erstenmal beschrieben wurden

Die Schrecken der Befreiung durch die ROTE ARMEE

Lud mein Zensor mich zu einem privaten Gespräch ein

Und der beamtete Leser zeigte mir stolz das verbotne

Typoskript in kostbares Leder gebunden SO

LIEBE ICH DEIN BUCH DAS ICH VERBIETEN MUSSTE

IM INTERESSE DU WEISST ES UNSRER GEMEINSAMEN SACHE

In der Zukunft sagte Boris Djacenko

Werden die verbotnen Bücher gebunden werden

IM INTERESSE DU WEISST ES UNSRER GEMEINSAMEN SACHE

In Leder gegerbt aus den Häuten der Schreiber

Halten wir unsre Haute intakt sagte Boris Djacenko

Damit unsre Bücher in haltbarem Einband

Überdauern die Zeit der beamteten Leser

(Heiner Müller : KULTURPOLITIK NACH BORIS DJACENKO in Warten auf der Gegenschräge. Gesammelte Gedichte. s.84)

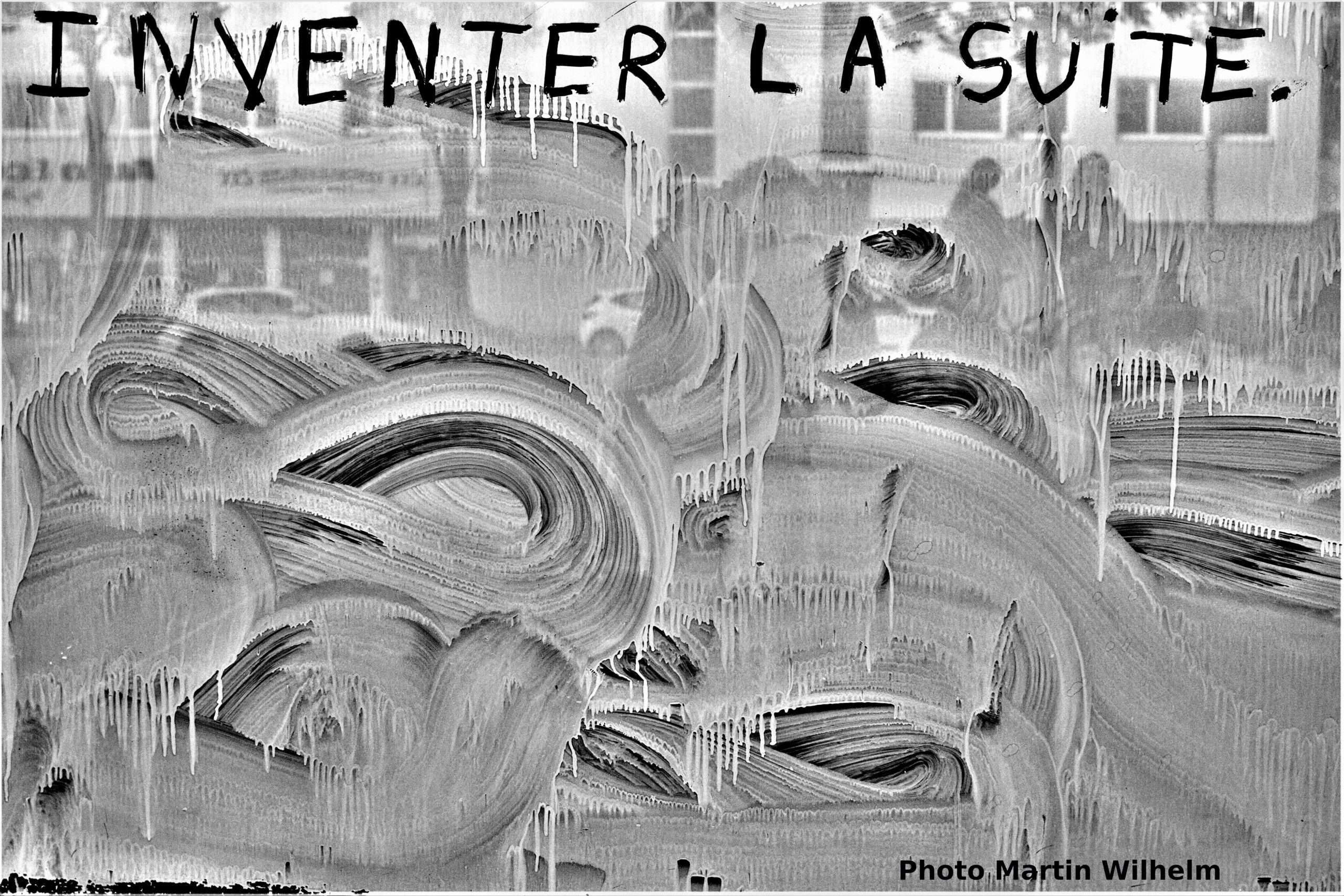

POLITIQUE CULTURELLE SELON BORIS DJACENKO

Boris Djacenko me dit Après l’interdiction

De mon roman CŒUR ET CENDRE Deuxième partie

Dans lequel pour la première fois furent décrites

Les horreurs de la libération par l’Armée Rouge

Mon censeur m’invita à une rencontre en privé

Ce lecteur officiel me montra fièrement le manuscrit

Interdit serré dans un cuir précieux C’EST AINSI

QUE J’AIME TON LIVRE QUE J’AI DU INTERDIRE

DANS L’INTÉRÊT TU LE SAIS DE NOTRE CAUSE COMMUNE

A l’avenir dit Boris Djacenko

Les livres interdits auront pour reliure

DANS L’INTÉRÊT TU LE SAIS DE NOTRE CAUSE COMMUNE

Le cuir de la peau des écrivains

Gardons intacte notre peau dit Boris Djacenko

Pour que dans cette reliure résistante nos livres

Survivent au temps des lecteurs officiels

(Heiner Müller : POLITIQUE CULTURELLE SELON BORIS DJACENKO. Trad. J. Jourdheuil, J.-F. Peyret) in Heiner Müller : Poèmes 1949-1985. Christian Bourgois. p.91)

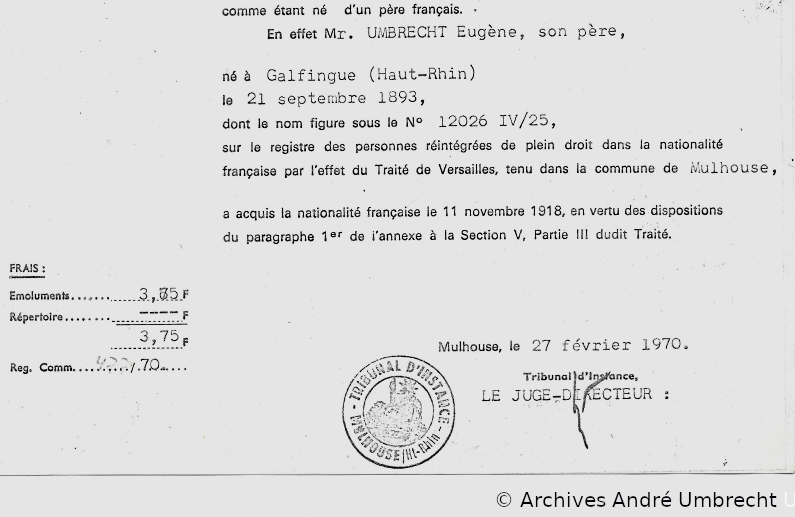

Beamteter Leser désigne le lecteur fonctionnaire d’une administration. Il est payé pour lire et pour, le cas échéant, repérer les passages suspects afin de les censurer. Il se distingue du lecteur amateur (amat=qui aime) et n’est pas à confondre, surtout dans ce cas particulier, avec le lecteur de la maison d’édition. Ici Neues Leben maison d’édition de la FDJ (Jeunesse libre allemande, organisation de jeunesse du SED, parti communiste est-allemand). En février 1958, le lecteur de Boris Djacenko, Karl Heinz Berger, et le directeur-adjoint de la maison d’édition ont été licenciés. On leur reprocha d’avoir encouragé la publication du second tome du roman Coeur et cendre de Boris Djacenko, dont des passages ont été jugés antisoviétiques. « Le directeur Bruno Petersen qui passait pour un camarade expérimenté et politiquement vigilant et le rédacteur en chef Sellin ont subi de lourdes sanctions disciplinaires du parti » dont ils étaient membres. (Siegfried Lokatis : Der rote Faden. Kommunistische Parteigeschichte und Zensur unter Walter Ulbricht )

On peut aussi penser aux lecteurs industriels de la société de marché.

Je signale par ailleurs que Schreck, Schrecken signifie l’effroi. (Voir ici). « Les effrois de la libération par l’Armée rouge ».

Qui était Boris Djacenko ?

Boris Djacenko est un écrivain de langue allemande d’originé lettonne. Il est né le 10 septembre 1917 à Riga, en Lettonie et mort à Berlin-Est le 14 avril 1975. Opposant au gouvernement de Kärlis Ulmanis, il est exclu de l’Université dont il suivait les cours de philosophie en auditeur libre. Pour échapper à une probable arrestation, il embarque en passager clandestin sur un bateau pour Rotterdam, en 1939. Arrivé à Paris en 1940, il est arrêté et emprisonné au Camp du Vernet dans l’Ariège où furent internés nombre de Républicains espagnols, de communistes et d’anti-fascistes allemands. Déporté en Allemagne, contraint au travail forcé, il fait une tentative d’évasion vers la Lettonie après l’agression allemande sur l’Union soviétique en 1941. Arrêté au Danemark, il est emprisonné à Flensburg dans le nord de l’Allemagne d’où il s’évade à nouveau. Clandestin à Berlin, il rejoint un groupe de résistance de travailleurs forcés. A l’arrivée de l’Armée rouge, il collabore avec l’administration soviétique, est maire provisoire de Töplitz (qui fera plus tard partie de Werder (Havel) dans le Brandenburg), journaliste à la Tägliche Rundschau, journal édité dans l’est de l’Allemagne par l’Armée rouge. Auteur de romans, de nouvelles et de pièces de théâtre, il vit de sa plume à partir de 1950.

Le premier tome de son roman Coeur et cendre paraît en RDA en 1954. Une seconde édition sera publiée dès l’année suivante. D’autres suivront. Boris Djacenko y raconte l’histoire de Carla Lautenschläger, une jeune femme qui avait aidé dans sa fuite un travailleur forcé soviétique, Igor Pertuchow et s’est retrouvée en contact avec un groupe de résistance dans le nord de l’Allemagne. Igor réussit à se rendre à Berlin pour y poursuivre un travail clandestin. Carla et d’autres résistants sont arrêtés et internés. Djacenko évoque le destin des prisonniers sur fond de victoire des armées alliées. A la fin du roman, Carla met au monde un enfant que ses co-détenus se font un devoir de protéger. (Source en allemand)

Si le poème de Müller est daté de novembre 1989, ce n’est qu’en 2010, plus de 50 ans après son écriture, en 1958, et son interdiction, que le second tome de Coeur et cendre, a été montré à l’Académie des Arts de Berlin. L’écrivain et théoricien de la littérature, Werner Liersch, qui avait sauvé le seul exemplaire existant des épreuves du livre, l’y avait présenté (lien en allemand).

Dans le second tome, Boris Djacenko reprend les personnages de la première partie avec, cette fois, en arrière plan, l’entrée de l’Armée rouge en Allemagne. Il y parle des exactions et des viols commis par les soldats soviétiques sur les femmes allemandes. Il évoque le système du goulag en URSS, et la traque par les Soviétiques de techniciens allemands en astronautique à Peenemünde. Et cela peu après le lancement de la fusée Soyouz et du premier satellite Spoutnik par l’Union soviétique, en 1957. Ces sujets ont été jugés inacceptables par les dirigeants est-allemands. Ils ont été déclarés tabous alors même que Staline était mort en 1953 et que le rapport Khrouchtchev dénonçant les crimes de Staline avait été révélé en 1956. Et que l’on pouvait croire à une littérature du dégel. Dégel est le titre d’un écrit de Ilya Ehrenbourg, paru en 1954. Le signal du pouvoir était clair : il n’y aura pas de littérature du dégel en RDA. Le tabou durera longtemps malgré les efforts de la littérature de le briser petit à petit. Boris Djacenko ne se remettra pas de cette censure et n’écrira plus que des romans policiers sous le pseudonyme de Peter Adams.

Je ne vais pas faire ici l’histoire de la censure en RDA, il y a amplement matière et touche à bien d’autres sujets mais il faudrait aussi parler des manières de la contourner. Elle prend des formes diverses et elle est évolutive. Je vais cependant très succinctement inscrire celle portant sur les viols et les exactions des libérateurs dans son histoire. L’un des premiers à en être frappé est Edgar Morin. Se retrouvant chômeur, il se rend avec Robert Antelme, en 1950, à Berlin-Est récupérer leurs droits d’auteur. E. Morin témoigne :

« Nous savions que nos livres avaient été publiés en RDA: le mien, L’An zéro de l’Allemagne, vendu à 50 000 exemplaires aux éditions Volk und Welt, dans une traduction où avait été expurgé mon chapitre sur la zone soviétique dans lequel, bien qu’atténuant leur cruauté, je faisais état des viols et exactions ».

(Edgar Morin : Mes Berlin/ 1945-2013. Cherche Midi 2013.

Là, il ne s’agit pas de la censure d’un livre entier. Seul un chapitre avait été effacé et l’édition originale, en français, est restée disponible même si elle a failli déplaire au Parti communiste français.

« Les effrois de la libération par l’armée rouge ont été bien plus résolument tabouisés par la censure que tout autre sujet. Les débats politiques sur la censure à ce sujet ne concernaient toutefois pas en général des livres soviétiques, mais des romans comme Herz und Asche de Boris Djacenko (1958) et Tod am Meer de Werner Heiduczek (1977) ainsi que le Journal de travail de Bertolt Brecht. »

(Siegfried Lokatis : Der rote Faden. Kommunistische Parteigeschichte und Zensur unter Walter Ulbricht p.128. Traduit par mes soins)

Pour Boris Djacenko, c’est un roman entier qui est interdit et son auteur condamné au silence et, presque, dans le silence si ce n’est comme signal en direction des responsables éditoriaux. Même son cas, n’était peut-être le poème de Heiner Müller, était tombé dans l’oubli.

« Boris Djacenko s’est fait écorcher vif. Ni CŒUR ET CENDRES, deuxième partie, ni son cas n’ont survécu au temps. […]. En 1958, le parti agissait encore à visage découvert et sans être inquiété. Djacenko appartenait à la préhistoire des affaires, où sa toute-puissance s’effritera de cas en cas. Pas d’agitation politique autour de Djacenko comme lors de la déchéance de citoyenneté de Biermann. Pas de solidarité de ses collègues comme lors de l’exclusion de Stefan Heym et de ses pairs de l’Union des écrivains. Pas d’Occident en attente de manuscrits interdits. C’est une histoire qui date de la préhistoire de l’intérêt de l’Allemagne fédérale. Djacenko doit s’en sortir tout seul. Il n’y parvient pas, comme il ne parvient pas à se faire une place dans les exemples de victimes de la censure ».

(Werner Liersch : Der Fall Djacenko. Wie ein unbequemes Buch verboten wurde und Erwin Strittmatter eine Wende vollzog: Unerwünschte Vergewaltigungen. Berliner Zeitung 25.01.2003)

C’est un petit peu moins vrai aujourd’hui.

Pour Brecht, la situation est encore autre mais porte en partie sur le même thème du libérateur agresseur. En 1965, à l’approche du 10ème anniversaire de sa mort, se posa la question d’éditer son Journal, en RDA. Le célèbre dramaturge avait cependant pris la précaution de confier parallèlement les droits de publication de ses œuvres complètes à l’éditeur ouest-allemand Suhrkamp qui imprima tome après tome. Helene Weigel s’étant opposé à toute coupe dans le Journal, ce dernier ne paraîtra pas en Allemagne de l’Est pour l’occasion. ( Cf Simone Barck ; Martina Langermann ; Siegfried Lokatis :„Jedes Buch ein Abenteuer“ : Zensur-System und literarische Öffentlichkeiten in der DDR bis Ende der sechziger Jahre. Berlin. Akademie Verlag. 1997)

Voici l’un des passages en cause. Il est daté du 25 octobre 1948 :

« aujourd’hui encore, trois ans plus tard, frémit parmi les travailleurs, à ce que j’entends dire partout, la panique occasionnée par les pillages et les viols après la conquête de Berlin. dans les quartiers ouvriers, on avait attendu les libérateurs avec une joie désespérée, les bras étaient grands ouverts, mais la rencontre se changea en agression, qui n’épargna ni les septuagénaires ni les enfants de douze ans et fut perpétrée en pleine lumière. on rapporte que les soldats russes, même pendant les combats de maison en maison, couverts de sang, épuisés, farouches, arrêtaient le tir pour que les femmes puissent aller chercher de l’eau, accompagnaient les affamés de leur cave à la boulangerie, aidaient à dégager les victimes sous les ruines, mais après la bataille des hordes ivres parcoururent les habitations, s’emparèrent des femmes, abattirent les hommes et les femmes qui résistaient, violèrent sous les yeux des enfants, faisaient la queue devant les maisons etc. kuckhahn [Heinz Kuckhan assistant de Brecht] a vu une septuagénaire tuée par balle après le viol, il a vu aussi un commissaire abattre deux soldats qui avaient pillé et qui l’attaquèrent lorsqu’il leur demanda des comptes. après toutes les dévastations matérielles que les armées nazies ont causées dans leur pays, les communistes russes devront encore faire face maintenant aux dévastations psychiques que la guerre de rapine hitlérienne a causées parmi les « moujiks » déshumanisés par le tsarisme, lancés depuis peu dans le processus de civilisation. »

(Bertolt Brecht : Journal de travail. 1938-1955. L’Arche. 1976. Trad Philippe Ivernel.. p.484-485)

Le Journal de travail de Brecht sera tout de même édité en RDA mais un peu plus de 10 ans plus tard, seulement en 1977 (Aufbau Verlag).

La même année sort le roman de Werner Heiduczek Tod am Meer non traduit en français, avant d’être interdit sur intervention de l’ambassadeur soviétique en RDA qui ne l’avait même pas lu. Il y a bien eu une svère critique dans l’organe central du SED mais elle constituait une excellente publicité pour le livre dont les exemplaires restant ont été retirés des librairies.

Ces cas de censure se sont fait dans une relative discrétion. Peu de publicité en RDA même. Ce sera différent pour un autre cas assez proche de celui de Boris Djacenko. Werner Bräunig sera lui aussi cloué au pilori mais pour de tout autres raisons . Son grand roman, Rummelplatz, sur les débuts de la RDA et le monde du travail restera inachevé et ne paraîtra jamais du temps de la RDA. Il sera édité en 2007 et non traduit en français. Le roman fut interdit « parce qu’il décrivait la réalité », dira Heiner Müller. Il fera l’objet, en 1965, à travers la publication d’extraits dans des revues et journaux, d’une véritable campagne de dénigrement de la part du parti communiste est-allemand (SED). Il mèna la charge pour affirmer qu’il était le seul détenteur de la vérité sur la société est-allemande et imposer le mythe de la monosémie. Werner Bräunig ne s’en remettra pas non plus. J’y reviendrai prochainement.

Il y a eu encore bien d’autres tabous en RDA. Je le les évoquerai pas ici si ce n’est pour signaler que le mot censure lui-même était prohibé. L’usage du mot censeur par Heiner Müller et non d’un euphémisme n’est pas innocent.

Heiner Müller et Boris Djacenko

Heiner Müller connaissait Boris Djacenko. Il l’avait rencontré une première fois au cours d’un stage d’écrivains en 1949 où ce dernier était venu parler du réalisme socialiste. « Il est venu dans la salle, a regardé autour de lui, s’est dirigé vers moi, m’a serré la main et a commencé à parler. Nous ne nous étions jamais vus », racontera le dramaturge dans son autobiographie. (p.46). Plus tard, Müller publiera, dans la Neue Deutsche Literatur (NDL 3.1954), la critique de l’un des recueils de nouvelles de Djacenko, Das gelbe Kreuz (Verlag Neues Leben 1953). Müller écrira notamment :

« Les héros ne sont pas des statues, les ennemis ne sont pas décrits comme des salopards chimiquement purs, il n’y a dans le livre pas trace de schématisme. Cette honnêteté artistique plaide pour le talent de Djacenko. De langue maternelle lettonne, son allemand reste à affiner pour le débarrasser des dernières malformations et mots jargonnants ».

(H. Müller : Novellen aus unserer Zeit in Heiner Müller Werke 8 / Schriften. Suhrkamp. p.73-75. Traduit par mes soins).

En 1961, Boris Djacenko était venu assister à un filage de scènes de la pièce de Heiner Müller, Die Umsiedlerin / La déplacée qui fut interdite le soir même de la première. Sa présence lors d’une séance de contrôle organisée pour le parti communiste a été interprétée par la suite comme un élément de preuve de l’existence d’une conspiration.

« Boris Djacenko est venu, il sortait juste de chez le dentiste et avait une joue enflée, ce qui accentuait encore son accent russe, et il a parlé avec emphase, avec son accent russe, en faveur de ce spectacle. Les camarades ont été impressionnés et se sont dit : si les Russes sont pour, il faut que nous soyons prudents. Nous n’avions pas présenté Djacenko, cela a été interprété ensuite comme une attitude sournoise de notre part — le fait que nous aurions mis un Russe en avant pour endormir la vigilance du Parti. Il n’était pas tellement connu, malgré Cœur et Cendre dont la deuxième partie avait été interdite parce qu’il avait été le premier à y décrire les viols qui ont eu lieu pendant et après la Deuxième guerre mondiale, et parce qu’il avait dit la vérité au sujet de l’avancée de l’Armée Rouge. Mais les fonctionnaires qui étaient présents ont pensé : c’est un Russe, et il est pour, donc cela ne peut pas être faux. Ils ont donc argumenté très prudemment ».

(Heiner Müller : Guerre sans bataille / Vie sous deux dictatures/ Une autobiographie. L’Arche. Trad. Michel Deutsch. p. 136)

Métamorphose du mythe de Marsyas

Titien : Le Supplice de Marsyas

Les universités allemandes quittent la plateforme « X » (anc. twitter)

Illustration: HHU/Paul Schwaderer

Plus de 60 établissements d’enseignement supérieurs et de recherche parmi les plus importants d’Allemagne et un autrichien ont choisi d’annoncer ensemble leur volonté commune d’interrompre leurs activités sur la plateforme X (anciennement Twitter).

Ce retrait est justifié par le constat d’une incompatibilité entre les orientations actuelles de la plate-forme et les valeurs fondamentales de l’enseignement supérieur que sont l’ ouverture sur le monde, l’intégrité scientifique, la transparence et le débat démocratique.

« Les modifications apportées à la plateforme X – depuis le renforcement algorithmique des contenus populistes de droite jusqu’à la limitation de la portée organique – rendent la poursuite de son utilisation inacceptable pour les organismes participants. Le retrait souligne leur engagement en faveur d’une communication basée sur les faits et leur opposition aux forces antidémocratiques. Les valeurs qui promeuvent la diversité, la liberté et la science ne sont plus présentes sur la plateforme. »

précise le communiqué.

Il ne propose pas d’alternative mais certaines universités ont d’ores et déjà développé leur propre plateforme Mastodon. La décision ne concerne pour l’instant que celle d’Elon Musk. Mais les développements des autres réseaux sociaux et de leurs algorithmes devraient être suivis avec attention.

Côté syndical aussi

Pour des raisons analogues, deux importants syndicats allemands, ver.di, syndicat unifié des services, et la Gewerkschaft Erziehung und Wissenschaft (GEW), regroupant enseignants et éducateurs, ont également annoncé leur retrait de la plateforme.

La Cour fédérale d’Allemagne a fait de même sans toutefois commenter sa décision

Les institutions universitaires signataires :

• Alanus Hochschule für Kunst und Gesellschaft

• Bauhaus-Universität Weimar

• Berliner Hochschule für Technik

• Brandenburgische Technische Universität Cottbus – Senftenberg

• Christian-Albrechts-Universität zu Kiel

• Deutsche Ornithologische Gesellschaft

• Deutsche Sporthochschule Köln

• Europa-Universität Viadrina Frankfurt (Oder)

• Fachhochschule Dortmund

• FernUniversität in Hagen

• Freie Universität Berlin

• Friedrich-Alexander-Universität Erlangen-Nürnberg

• Goethe-Universität Frankfurt

• HAWK Hochschule für angewandte Wissenschaft und Kunst Hildesheim/Holzminden/Göttingen

• Heinrich-Heine-Universität Düsseldorf

• Hochschule Anhalt

• Hochschule Bonn-Rhein-Sieg

• Hochschule Darmstadt

• Hochschule der Bildenden Künste Saar

• Hochschule für Musik und Theater Hamburg

• Hochschule für Philosophie München

• Hochschule Furtwangen

• Hochschule München

• Hochschule Neubrandenburg

• Hochschule Osnabrück

• Hochschule RheinMain

• Hochschule Ruhr West

• Hochschule für nachhaltige Entwicklung Eberswalde

• Hochschule für Wirtschaft und Umwelt Nürtingen-Geislingen

• Humboldt-Universität zu Berlin

• Institut für Vogelforschung

• Johannes Gutenberg-Universität Mainz

• Justus-Liebig-Gesellschaft

• Justus-Liebig-Universität Gießen

• Katholische Hochschule Nordrhein-Westfalen

• Kirchliche Hochschule Wuppertal

• Leibniz-Zentrum für Marine Tropenforschung

• Leibniz-Institut für Ostseeforschung Warnemünde

• Medizinische Universität Innsbruck

• Philipps-Universität Marburg

• RWTH Aachen

• Technische Hochschule Georg Agricola

• Technische Hochschule Köln

• Technische Universität Braunschweig

• Technische Universität Darmstadt

• Technische Universität Dresden

• Universität Bamberg

• Universität Bayreuth

• Universität des Saarlandes

• Universität der Künste Berlin

• Universität Duisburg-Essen

• Universität Erfurt

• Universität Greifswald

• Universität Heidelberg

• Universität Innsbruck

• Universität Münster

• Universität Potsdam

• Universität Siegen

• Universität Trier

• Universität Ulm

• Universität Würzburg

• Universität zu Lübeck

• Westsächsische Hochschule Zwickau